В конце ноября 2022 года OpenAI выпустила ChatGPT для широкой публики и положила начало революции в области искусственного интеллекта. Несколько дней спустя генеральный директор Kolide пожаловался на слабину нашей компании и призвал нас опробовать эту новую “технологию, меняющую общество”.

Во всем мире начальники говорили своим сотрудникам одно и то же: начните играть с генеративным искусственным интеллектом и выясните, как он может сделать вас (и нас) быстрее, умнее, лучше. Менее чем через год этот совет приобрел поразительную популярность.

Опрос, проведенный Kolide среди более чем 300 работников умственного труда, показал, что 89% используют ту или иную форму искусственного интеллекта для выполнения своей работы не реже одного раза в месяц. (И когда мы говорим “ИИ”, мы имеем в виду генеративные инструменты ИИ, построенные на основе LLM и основополагающих моделей, а не других форм машинного обучения.)

Эта единственная точка данных рассказывает убедительную историю сама по себе. Просто сравните скорость внедрения ИИ за один год с электронной почтой, которой потребовались десятилетия, чтобы достичь такого уровня насыщения.

Но история использования искусственного интеллекта сотрудниками становится еще более интересной и сложной, когда мы рассматриваем ее в контексте рисков, связанных с искусственным интеллектом. Опрос показал, что те же компании’ которые поощряют (или игнорируют) использование искусственного интеллекта своими сотрудниками, не обучают их тому, как безопасно им пользоваться.

В отчете Forrester о прогнозах искусственного интеллекта на 2024 год говорится, что “теневой искусственный интеллект будет распространяться по мере того, как организации будут бороться за удовлетворение спроса на сотрудников, создавая безудержные проблемы регулирования, конфиденциальности и безопасности”. Наши собственные выводы подтверждают эти опасения, но они также указывают на то, как компании могут опередить эти проблемы до того, как работа, созданная искусственным интеллектом, полностью и незаметно проникнет во всю их организацию.

Риски, связанные с искусственным интеллектом на рабочем месте: краткий обзор

Прежде чем мы углубимся в данные опроса, давайте кратко определим, что мы подразумеваем под рисками приложений, основанных на искусственном интеллекте.

Во-первых, мы не говорим о “экзистенциальных” рисках, о которых любят предупреждать нас основатели и сторонники искусственного интеллекта. Крайне маловероятно, что кто-то, читающий эту статью, развяжет ядерную войну или следующую пандемию с помощью чат-бота.

Мы также не говорим об опасности того, что ИИ заменит человеческий труд, и о том, что наибольший риск, на который идут работники, экспериментируя с ИИ, заключается в том, что они будут экспериментировать сами, не имея работы.

В данном случае нас интересуют типы рисков, которые ИИ создает для бизнеса, что может привести к юридическим, репутационным и финансовым последствиям. Вот несколько примеров таких рисков.

Ошибки искусственного интеллекта

Известно, что LLM, возможно, по своей сути, склонны к ошибкам, при которых они либо фабрикуют информацию, либо перерабатывают неверные данные обучения. (Ошибки такого типа часто описываются общим термином “галлюцинации”, хотя этот термин несколько проблематичен, поскольку он очеловечивает программное обеспечение и отвлекает внимание от компаний, ответственных за его создание.)

Мы могли бы написать целую блоге поучительных историй ИИ, но некоторые примеры включают адвоката, который подал записку, в которой привел вымышленные прецедентное право, выход новостей, которые напечатаны без ошибок пронизана историями, и поедая расстройства горячая линия, чат-бот , который посоветовал абонентам похудеть. Опасности здесь настолько значительны, что, по прогнозам Forrester, страховые компании вскоре будут предлагать компаниям “страхование от галлюцинаций ИИ”, хотя мы посмотрим, окажется ли это более жизнеспособным бизнесом, чем страхование кибербезопасности.

Безусловно, LLM могут принести реальную пользу работникам; наш собственный Джейсон Меллер красноречиво написал о том, как они дают ему отправную точку для решения сложных проблем с кодированием. Но, поскольку инструменты искусственного интеллекта выдают ложь с такой же уверенностью, как и факты, их работа должна быть тщательно проанализирована кем-то, обладающим достаточным опытом, чтобы выявить ошибки. (И это, очевидно, невозможно, если вы не знаете, используют ли сотрудники вашей компании искусственный интеллект или как именно.)

Наконец, мы должны упомянуть о возможности для LLM делать выводы, которые не являются строго “ошибками”, но которые увековечивают предубеждения общества. Это вызывает серьезную озабоченность законодателей; Представитель. Иветт Кларк из Нью-Йорка недавно заявила, что “предвзятость в ИИ станет проблемой гражданских прав нашего времени”. Например, если ваш отдел кадров использует инструменты с поддержкой искусственного интеллекта для проверки резюме, вы можете быть обязаны сообщать об этом соискателям в соответствии с новыми законами.

плагиат в области искусственного интеллекта

Несмотря на название, генеративный ИИ не способен генерировать какие-либо оригинальные результаты, а только извлекает из своих обучающих данных и переделывает их (что не означает, что его продукты не часто бывают полезными или занимательными).

Пока нет четкого консенсуса относительно того, является ли удаление и перенастройка ИИ существующего контента плагиатом и / или нарушением авторских прав. Для решения этого вопроса в судах рассматривается множество судебных исков, причем стороны в них варьируются от авторов до комиков и разработчиков. В случае с кодом мы много писали о разработчиках, которые утверждают, что GitHub Copilot приостановил их работу в нарушение лицензий с открытым исходным кодом.

Очевидно, что ни одна компания не хочет, чтобы в их кодовой базе или маркетинговых материалах скрывался иск об авторских правах, но риски здесь не просто юридические. Даже если компании, работающие с искусственным интеллектом, выиграют эти дела или найдут способ правильно ссылаться на свои источники, распространение принципиально неоригинальной работы влечет за собой последствия. Это может не иметь значения для внутренних вариантов использования, таких как отправка электронной почты или помощь в разработке электронной таблицы. Но если мы говорим о общедоступном контенте, то вы рискуете удешевить свой бренд некачественным контентом и потенциально быть наказаны с точки зрения SEO за неспособность обеспечить ценность.

Риски безопасности искусственного интеллекта

Последняя категория рисков искусственного интеллекта, которую мы коснемся, — это их потенциальная возможность утечки данных и взломов.

Во-первых, было обнаружено, что сгенерированный искусственным интеллектом код содержит известные уязвимости и другие недостатки безопасности. С другой стороны, произошел взрыв вредоносного ПО, маскирующегося под искусственный интеллект, особенно на Диком Западе браузерных расширений.

Многие компании также обеспокоены тем, что инструменты искусственного интеллекта будут перекачивать их коммерческие секреты для использования в качестве обучающих данных, хотя для некоторых инструментов эта функция может быть отключена. Наконец, злоумышленники могут делать джейлбрейк LLM и обманом заставлять их совершать вредоносные действия, такие как удаление данных пользователя без его ведома или согласия.

Искусственный интеллект на рабочем месте приветствуется, но плохо понимается

В отчете Shadow IT нас заинтересовало использование искусственного интеллекта сотрудниками как пример того, как компании реагируют на новые технологии и разрабатывают политику, регулирующую их использование. Мы опросили сотрудников на всех уровнях корпоративной лестницы – от первого этажа до C–Suite — и с разным уровнем технических знаний, хотя все респонденты используют компьютеры для выполнения основной части своей работы.

В частности, нам было любопытно узнать:

- Сколько компаний разрешили использование искусственного интеллекта и использовало ли его больше сотрудников, чем было разрешено.

- Насколько хорошо компании информировали своих сотрудников о рисках искусственного интеллекта или устанавливали ограничения вокруг инструментов, которые они могли бы использовать.

- Имели ли работники точное представление о том, как их коллеги используют искусственный интеллект.

Давайте изложим наши выводы по порядку.

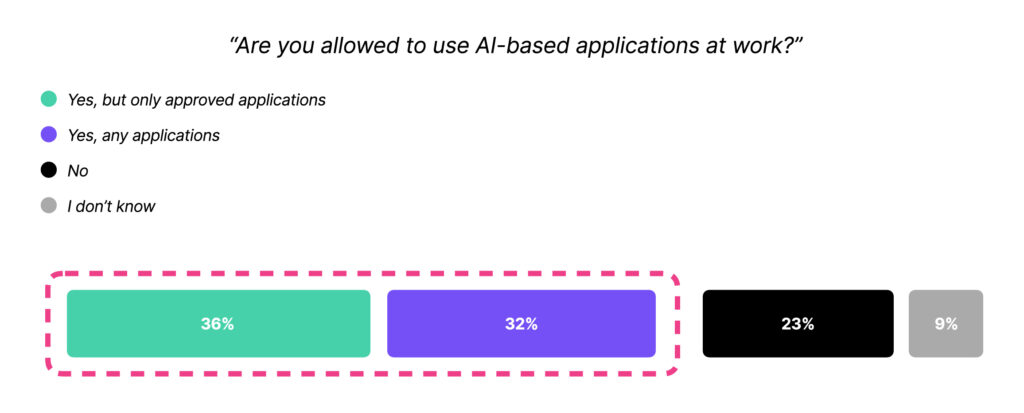

68% компаний разрешают использование искусственного интеллекта

Существует значительное расхождение между 68% респондентов, которые говорят, что им разрешено использовать искусственный интеллект для работы, и 89%, которые говорят, что они его используют. Этот пробел означает, что сгенерированные искусственным интеллектом тексты, изображения и код незаметно проникают в результаты нашей работы, не подвергаясь дополнительной проверке.

Также важно признать огромную разницу между 36% компаний, которые разрешают только одобренные приложения с искусственным интеллектом, и 34%, которые придерживаются неограниченной политики в области искусственного интеллекта. Учитывая распространение инструментов искусственного интеллекта с сомнительными политиками конфиденциальности и безопасности данных, не говоря уже о тех, которые являются просто вредоносным ПО, замаскированным под искусственный интеллект, вызывает беспокойство тот факт, что так много компаний не имеют ограничений.

Между тем, почти четверть компаний прямо запрещают сотрудникам использовать искусственный интеллект, ставя их в один ряд с Samsung, Spotify, Apple и другими корпорациями, обеспокоенными конфиденциальностью и безопасностью данных.

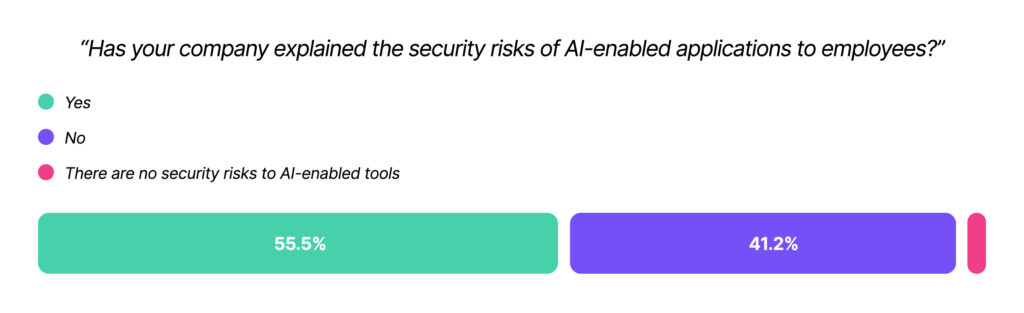

Только 56% компаний информируют работников о рисках, связанных с искусственным интеллектом

Опять же, мы видим расхождение между 68% респондентов, которым разрешено использовать искусственный интеллект, и 56%, которые были обучены тому, как использовать его ответственно.

Мы можем объяснить этот недостаток образования несколькими факторами. Во-первых, “риски искусственного интеллекта” горячо обсуждаются даже среди экспертов в этой области, поэтому руководители среднестатистической компании могут не иметь четкого представления о том, что это такое. Кроме того, многие компании (к сожалению) рассматривают обучение сотрудников безопасности не более чем как контрольное упражнение, поэтому у них нет ни инструментов, ни культуры реагирования на возникающие угрозы. Еще один вывод опроса заключается в том, что средняя компания (41%) проводит обучение по вопросам безопасности только раз в год, поэтому некоторые сотрудники, возможно, не проходили обучение еще до того, как появился нынешний набор LLM.

Стремясь дополнить результаты нашего опроса, мы объявили конкурс предложений по использованию искусственного интеллекта на рабочем месте. Мы получили более 100 ответов, и, что обескураживает, хотя и неудивительно, многие из них явно были написаны искусственным интеллектом. Однако большинство людей согласились с тем, что у них есть опасения по поводу этических последствий ИИ для конфиденциальности, но на их рабочем месте нет официальной политики в отношении этого. Процитируем одного респондента: “Существует общее понимание того, что если ИИ помогает выполнять работу лучше, то почему бы и нет?”

Последняя причина, по которой компании не воспринимают всерьез использование искусственного интеллекта сотрудниками, заключается в том, что они просто не осознают, что это происходит.

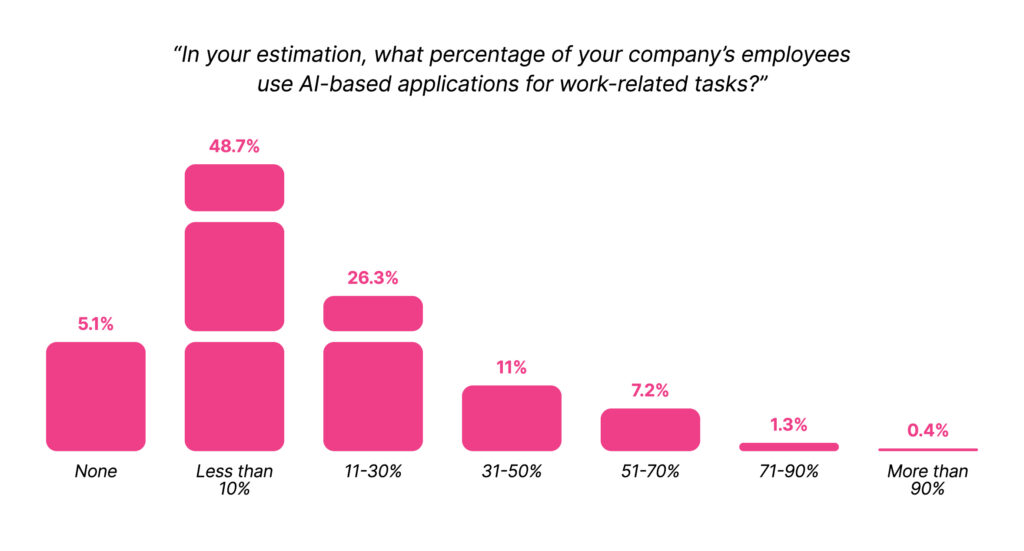

Работники сильно недооценивают, насколько их коллеги используют искусственный интеллект

Это был самый неожиданный результат нашего опроса. Несмотря на то, что большинство работников используют ИИ и большинство компаний разрешают это, средний работник предполагает, что он единственный, кто им пользуется.

Примерно половина респондентов заявили, что менее 10% их коллег используют ИИ. Только 1% респондентов правильно предположили, что истинное число ближе к 90%.

Как мы можем объяснить этот дикий разрыв между нашими представлениями о том, как работники используют искусственный интеллект, и реальностью? Возможно, это просто знакомая смесь самодовольства и смущения, которые мы все испытываем, когда думаем, что нашли короткий путь, которым больше никто не пользуется, – например, тайком ходим перекусить в кино или крутим мышкой вместо работы *.

Независимо от того, почему мы так ошибаемся, недостаток осведомленности создает опасную среду. Компании не в состоянии регулировать использование искусственного интеллекта работниками, потому что не считают это необходимым. Это необходимо изменить.

* Не то чтобы этот автор когда-либо делал или когда-нибудь сделал бы что-то подобное.

Вам нужна Политика приемлемого использования искусственного интеллекта прямо сейчас

Существуют законно интересные и полезные приложения для генеративных инструментов искусственного интеллекта, но единственный способ, которым эти преимущества могут перевесить риски, — это создать политику, предписывающую ответственное использование искусственного интеллекта.

Какими должны быть цели этой политики? Для нас это было следующее:

- Привлечение внимания к использованию искусственного интеллекта работниками

- Предотвращение наиболее небезопасных видов использования искусственного интеллекта

- Разработка приемлемой политики использования искусственного интеллекта

Это процесс, через который мы прошли и продолжаем проходить, чтобы выработать нормы и ожидания в отношении использования искусственного интеллекта в Kolide.

Обеспечить наглядность использования искусственного интеллекта работниками

Есть причина, по которой данные опроса Kolide об ИИ на рабочем месте являются частью нашего отчета о теневых ИТ; если работники используют ИИ без ведома или надзора компании, то это следует рассматривать как форму теневых ИТ. Но, как мы писали ранее, вы не можете просто наложить полный запрет на любую неутвержденную технологию и считать проблему решенной. Работники обойдут ваш запрет, если посчитают, что им нужен инструмент для выполнения своей работы.

Любая попытка привлечь внимание должна осуществляться в форме непредвзятого разговора, направленного на то, чтобы понять, как работники ИИ в настоящее время используют ИИ и что они получают от этого. Даже если этот процесс выявит некоторые нежелательные используемые инструменты, это следует использовать как возможность рассказать пользователям о рисках и предложить более безопасные альтернативы.

Предотвращайте самые рискованные формы искусственного интеллекта

Учитывая риски, о которых мы только что говорили, вы, вероятно, не хотите, чтобы сотрудники вашей компании подключали конфиденциальные данные ваших клиентов к непроверенному инструменту искусственного интеллекта, который они скачали из Интернета. Вы также можете захотеть заблокировать неутвержденные расширения браузера или вообще запретить использование инструментов программирования, таких как Copilot.

То, что вы решите разрешить или заблокировать, зависит от вашей личной толерантности к риску, но независимо от этого, блокировка должна быть принудительной, чтобы работать. Другими словами, если вы заблокируете инструмент искусственного интеллекта на всех устройствах, управляемых компанией, но работник может получить доступ к тем же данным на своем персональном компьютере, вы не решите проблему, вы просто уберете ее из поля зрения. (Подробнее об этой проблеме мы поговорим в отчете о теневых ИТ и в нашем сообщении в блоге на эту тему.)

Совместно разрабатывайте политику приемлемого использования инструментов искусственного интеллекта

По всей вероятности, вам действительно понадобятся две политики: один официальный юридический документ и другой, содержащий повседневные рекомендации. Возможно, вам понадобится юрист для написания первого, но для создания второго необходимо получить информацию от заинтересованных сторон из нескольких отделов.

“получить информацию от заинтересованных сторон из нескольких отделов” — это, вероятно, самый распространенный и наиболее игнорируемый совет в бизнесе, но это действительно важный шаг, если вы хотите, чтобы политика работала. В случае с Kolide мы быстро поняли, что у маркетинга, операций и инжиниринга разные потребности, поэтому соответствующим образом адаптировали политику.

Результатом стала приемлемая политика использования, которая переходит:

- Ограничение конфиденциальных данных, которые мы предоставляем инструментам искусственного интеллекта

- Отключение функций обучения

- Осознавать предвзятость и избегать ее

- Работа по маркировке значительно дополняется искусственным интеллектом

- Список одобренных компанией инструментов искусственного интеллекта

- Приглашение поделиться другими инструментами с командой

Целью нашей политики было создать среду, в которой сотрудники не чувствовали бы давления с целью использования искусственного интеллекта и не были бы наказаны за это. У вашей организации могут быть разные цели, но важно намеренно и открыто заявлять о том, каковы они. Это лучший и единственный способ вывести искусственный интеллект из тени.