Исполнительный директор по защитной разведке в Ontic, эксперт по безопасности, автор бестселлера New York Times и бывший специальный агент.

Когда я начинал свою карьеру следователя по борьбе с терроризмом, добывать информацию было намного сложнее. Единственная зацепка добывалась с трудом и часто требовала поиска по крошкам и повторных шагов. Данные в реальном времени были еще более редкими, поскольку мир еще не был соединен цифровым способом.

За последние 15 лет распространение цифровой информации стало благословением и проклятием для всех в индустрии безопасности. Она обеспечила пожарный рукав новыми точками данных, доступными мгновенно из любого уголка земного шара. Во многих случаях идеи, предлагаемые этими новыми типами цифровой информации, уникальны и весьма ценны — просто взгляните на быстро расширяющуюся область разведданных с открытым исходным кодом.

Но эти достижения также значительно усложнили работу специалистов по корпоративной безопасности и следователей. Например, хотя развитие социальных сетей значительно упростило быстрый поиск информации, также возросла вероятность того, что вы отслеживаете неточные или предвзятые данные, случайно или намеренно.

Сегодня следователи и аналитики спецслужб сталкиваются с аналогичной, но иной проблемой, которая связана с «генеративным искусственным интеллектом», включая такие сервисы, как ChatGPT или Stable Diffusion. Эти программы «генерируют» текст, изображения, аудио или видео в ответ на запросы пользователя. Легкость, с которой эти инструменты создают изображения и видео, наряду с их невероятной скоростью и точным внешним видом, угрожает завалить аналитиков спецслужб и частных лиц сетью хорошо продуманных мистификаций, дезинформации или дезинформации.

В сочетании с использованием социальных сетей генеративный ИИ обладает потенциалом для масштабного распространения вреда и злонамеренных намерений. Одной из самых больших проблем в будущем вполне может стать выделение сигналов из шума онлайн-контента, генерируемого ИИ. И такое положение дел поднимет несколько сложных и почти философских вопросов. А именно, как нам отделить факт от вымысла? Откуда мне знать, что эта подсказка, над которой я так усердно работал, на самом деле правдива?

Группам безопасности и аналитикам разведки понадобятся инструменты и обучение, которые помогут им отсеивать ложные указания, полуправду и откровенные измышления, чтобы сосредоточиться на важной информации и угрозах.

Высокий потенциал для хаоса

Хаос, который может создать генеративный ИИ, огромен. В мае в социальных сетях появилось сгенерированное ИИ изображение, на котором были изображены последствия взрыва в Пентагоне. Такого взрыва не произошло, но некоторые новостные агентства распространили это заявление, и фондовый рынок США ненадолго снизился на фоне этих новостей.

Но представьте, как подобную тактику можно было бы использовать для нападения на конкретную организацию или руководителя по различным причинам. Например:

- Созданное искусственным интеллектом видео вашего генерального директора размещено в Интернете, объявляя о ложных корпоративных изменениях или продуктах, выпущенных для манипулирования курсом акций компании или для продвижения программы активистов.

- Поддельный телефонный звонок с использованием голоса вашего финансового директора, сгенерированного искусственным интеллектом, просит подчиненного из финансовой команды провести мошенническую финансовую транзакцию, аналогичную продвинутой — и, вероятно, очень убедительной — версии мошенничества с компрометацией деловой электронной почты.

- Поддельные учетные записи сотрудников создаются в LinkedIn и профессиональных ассоциациях с использованием текста, изображений и видео, сгенерированных искусственным интеллектом, для социальной инженерии команды.

- Созданное искусственным интеллектом видео используется для совершения виртуальной аферы с похищением руководителей, служащих или детей с высоким уровнем дохода.

Как технологии могут помочь

Хотя индустрия искусственного интеллекта только зарождается, многие в этой области понимают необходимость отделять факты от вымысла. Уже существует множество инструментов, призванных определять разницу между контентом, созданным людьми, и контентом, созданным машинами. Эти инструменты могут быть полезны в некоторых случаях, но на данный момент их точность под вопросом.

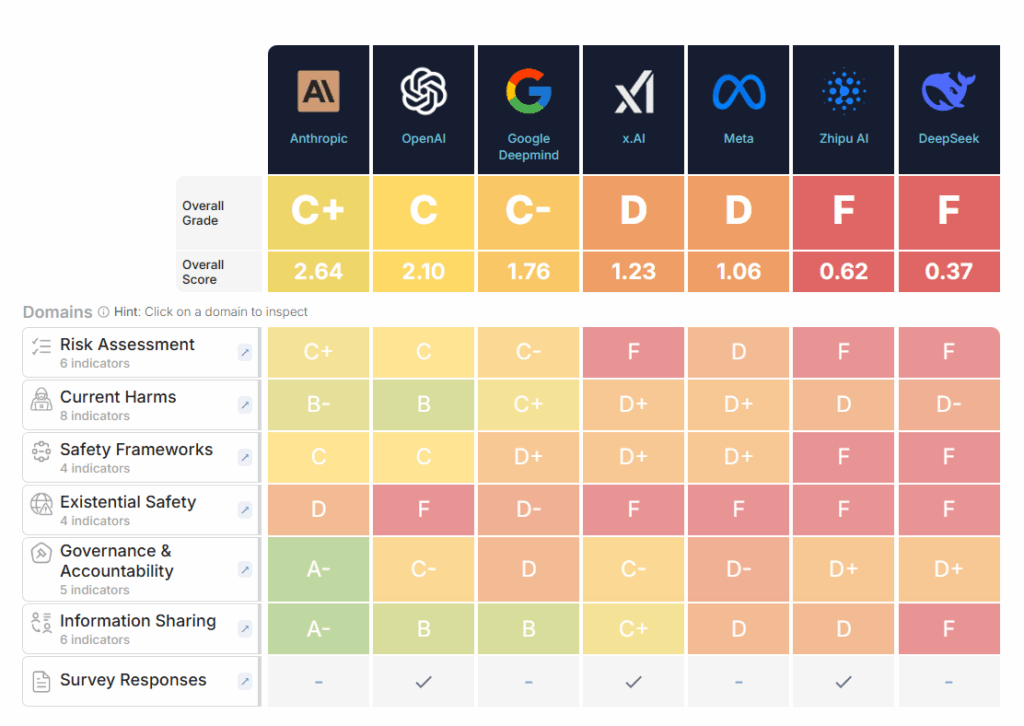

Семь крупных компаний, занимающихся искусственным интеллектом, недавно добровольно взяли на себя обязательство разработать систему «водяных знаков» для всех видов контента, от текста и изображений до аудио и видео, генерируемых искусственным интеллектом, чтобы пользователи знали, когда технология использовалась.

Эти усилия по обеспечению прозрачности приветствуются, но без аналогичных усилий по всей отрасли, особенно включая компании, базирующиеся в странах, которые не часто придерживаются такого добровольного регулирования, проблема обнаружения недостоверного контента будет сохраняться. В ближайшие несколько лет, скорее всего, начнется гонка вооружений между разработчиками средств обнаружения и теми, кто сеет зло.

Для специалистов по корпоративной безопасности станет еще более важным отслеживать угрозы и вредоносную информацию, а также совершенствовать методы и процессы управления обращениями, чтобы ваша команда могла триангулировать все доступные данные. Вероятно, мы увидим рост систем, использующих несколько типов данных для идентификации и аутентификации разведывательной информации.

В идеале эти системы могли бы быть полезны для идентификации преступников или их мотивов или даже для аутентификации контента. Лучше всего эти системы будут использоваться командами, которые уже разработали и внедрили надежные системы расследования и анализа, а затем смогут более эффективно интегрировать новые точки данных.

До тех пор организации должны удвоить меры, которые они уже могут предпринять, чтобы пресечь угрозы и мистификации. Следует разработать планы быстрого реагирования, потенциально включающие настольные учения, для рассмотрения того, как противостоять последствиям онлайн-мистификаций и средств массовой информации, наносящих ущерб.

Также следует активизировать обучение сотрудников социальной инженерии и другим подобным формам компромисса, уделяя особое внимание элементу здравого смысла и практическому предотвращению угроз. Для противодействия таким ситуациям группам безопасности часто лучше всего помогает внутреннее партнерство. Партнерские отношения между такими командами, как отдел кибербезопасности и отдел кадров, могут стать важнейшим инструментом для решения этих проблем.

Что еще более важно, всем нам нужно выработать в себе еще более здоровую дозу скептицизма. По мере того, как мы движемся в будущее, в котором, казалось бы, доступные подсказки просеиваются сквозь наши пальцы, как песчинки, одной из важнейших задач специалистов по безопасности и аналитиков будет быстрое принятие решений с использованием доступной информации для обеспечения безопасности персонала и операций.

Сделать это будет намного проще с аналитическими инструментами, которые поддерживают быстрый анализ с использованием всех известных точек данных, работающих в рамках заранее определенных процессов. Аналитики разведки и эксперты по безопасности не смогут сопоставить масштаб угроз от генерирующего искусственного интеллекта без технологий, прочных межфункциональных партнерств и собственных навыков рассуждения, позволяющих отделять сигналы от шума.

Исполнительный директор по защитной разведке в Ontic, эксперт по безопасности, автор бестселлера New York Times и бывший специальный агент.